编辑点评:网站管理分析工具

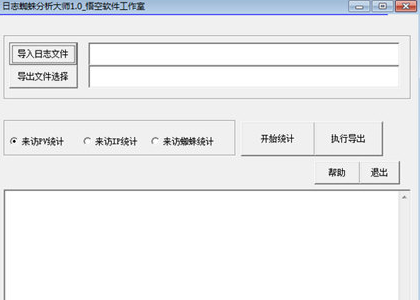

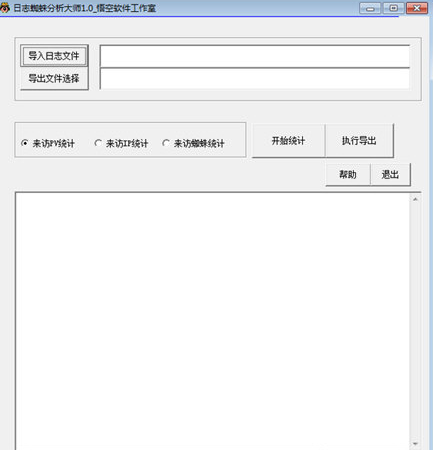

日志蜘蛛分析大师是一款非常好用的网站管理分析工具,能够帮助站长分析服务器日志的蜘蛛爬行纪录的软件,一键就能开始统计数据,并且还能用于执行导出,我们就可以以此为基础对网站进行优化,以提高曝光率

软件功能

该程序支持分析服务器日志得到关于IP/PV和各种蜘蛛的爬行记录,支持六大蜘蛛,支持24小时分析。

您可以直接导入.log日志文件进行分析。

来访PV统计,可以自动对来访的PV进行统计。

来访IP统计,可以自动对来访IP进行统计。

来访蜘蛛统计,可自动统计来访蜘蛛。

如何分析蜘蛛日志?

蜘蛛日志分析

什么是蜘蛛日志?

所谓的蜘蛛日志就是当搜索引擎向服务器发送请求时产生的访问记录文件。

每个网站都会有日志文件,但是很多时候,日志文件只有在网站出现问题的时候才会被查阅。在seo方面,日志文件是更容易被忽略的一块,但是日志文件对于seo来说事非常重要的,我们可以在日志文件中获取各种信息并发现网站存在的一些问题。

日志可以去哪里拿到?

日志文件一般是在wwwlog或者log这样的文件夹里面可以下载。

分析主要用什么工具?

python和loghao

在日志中可以查看哪些数据?

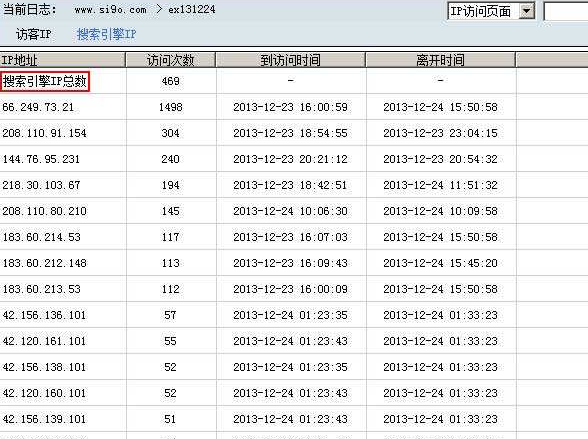

1.客户端的IP地址

2.访问时间

3.查看http状态码

4.请求方式等等

查看蜘蛛日志常用的一些命令

1.cat access.log | grep Baiduspider 命令来获取百度蜘蛛的详细爬取记录

2.cat access.log | grep Baiduspider | wc -l 命令来统计百度蜘蛛的爬取次数

3.cat access.log | grep Baiduspider | grep "GET url" 来统计百度蜘蛛爬取某个页面的记录,命令中的url为页面的相对地址。

grep指令用于查找内容包含指定的范本样式的文件,如果发现某文件的内容符合所指定的范本样式,预设grep指令会把含有范本样式的那一列显示出来。若不指定任何文件名称,或是所给予的文件名为-,

则grep指令会从标准输入设备读取数据。在分析日志的时候使用该工具,可以精确找出我们想看的日志内容,减少筛选时间,提升自身的工作效率。可以根据我们实际的场景,输入关键词来过滤日志。

蜘蛛日志有何作用?

1.通过对蜘蛛日志的分析,我们可以知道蜘蛛是否对站点进行了抓取,以及抓取是否成功,判断抓取资源是否被浪费,也可以判断我们的网站是否符合搜索引擎的抓取规范,找到抓取失败的原因。

2.如果某个页面被蜘蛛频繁地抓取,我们可以对这个页面做一些调整(比如布局),可以在页面中添加一些链接。但有些频繁地抓取是蜘蛛恶意的抓取,如果蜘蛛的访问频率过高,很可能会影响正常服务的运行,

通过对蜘蛛日志的分析,可以发现恶意蜘蛛的足迹,然后可以限制蜘蛛的访问频率来保证服务器的稳定。

3.通过分析日志文件,我们可以发现蜘蛛的访问路径,有次我们可以优化我们的站点结构。

总结:利用日志我们可以挖掘到很多的信息,我们可以通过日志中的状态码来分析网站是否存在问题,如是否存在死链,页面失效等错误。我们通过日志可以发现用户对整站页面的访问次数、

访问时间以及访问路径,通过这些可以分析用户的行为习惯。通过日志我们甚至可以防范恶意攻击,因此,日志分析在做网站的过程中是必不可少的。

loghao如何分析蜘蛛抓取首页次数呢?

如果你是iis日志,你的首页文件名称是“index.html”

在搜索区域,第一个输入“ /index.html ”,第二个输入蜘蛛名称“Baiduspider”,或蜘蛛留下的网址。

点击纠正即可。

如果你是apache日志,第一个输入“ / ”即可,第二个按照iis日志输入。

点击纠正即可。

同样,如果你要分析其他页面的抓取情况,也可以在这里根据你的需求输入,然后纠正。

你也可以点击其他权重蜘蛛,查看输入框的变化,根据输入框的变化,修改你要的个性分析数据。

Baiduspider蜘蛛=220.181.108权重首页+123.125.71低权重+123.125.68沙盒+220.181.68沙盒+220.181.7预备抓取+123.125.66预备抓取+121.14.89新站考察+203.208.60网站异常+210.72.225巡逻

123.125.68沙盒=404页面;

220.181.68沙盒=404页面;

123.125.71低权重=低质量内容;

220.181.108权重首页=高质量内容;

.html>.htm>.shtml>.php>.asp>.jpg>.gif>.png>.css>.js;

200>304>301>302>404>500;

220.181.108权重首页>123.125.71低权重>220.181.7预备抓取>123.125.68沙盒+220.181.68沙盒

微信电脑版客户端

微信电脑版客户端 钉钉pc客户端

钉钉pc客户端 夸克网盘PC端

夸克网盘PC端 阿里云盘PC客户端

阿里云盘PC客户端 360极速浏览器X

360极速浏览器X 向日葵远程控制软件

向日葵远程控制软件 ToDesk远程控制软件

ToDesk远程控制软件 火狐浏览器PC版

火狐浏览器PC版 浏览器vip插件破解版

浏览器vip插件破解版 CareUEyes(蓝光过滤护眼软件)最新版

CareUEyes(蓝光过滤护眼软件)最新版

WinSCP绿色中文版5.19.5 最新版

WinSCP绿色中文版5.19.5 最新版 网络ip切换软件NetSetMan破解版5.1.0 特别版

网络ip切换软件NetSetMan破解版5.1.0 特别版 极简站点管理器1.0 免费版

极简站点管理器1.0 免费版 万化网站一键部署软件1.0 免费版

万化网站一键部署软件1.0 免费版 精准SNTP软件1.0 最新免费版

精准SNTP软件1.0 最新免费版 大小: 27.1M

大小: 27.1M

pc网盘客户端

pc网盘客户端 淘宝双十二工具合集

淘宝双十二工具合集 不限速的PC下载软件

不限速的PC下载软件 PC下载工具合集

PC下载工具合集 电脑浏览器合集

电脑浏览器合集

热门评论

最新评论